Ocho principios de datos abiertos de gobierno

En diciembre del 2007 en Sebastopol, California, un grupo de treinta "defensores de gobierno abierto" para datos abiertos de gobierno, los cuales se detallan a continuación:

- Completo: todos los datos públicos está disponible. Los datos público no contempla datos privados ni limitaciones de seguridad o privilegios.

- Primario: los datos son recolectados en la fuente de origen, con el nivel de granularidad mas alto posible, no en forma agregada ni modificada.

- Oportuno: los datos están disponibles tan rápido como sea necesario para preservar el valor de los datos.

- Accesible: los datos están disponibles para el rango mas amplio de usuarios para el rango mas amplio de propósitos.

- Procesable por maquinas: los datos están estructurados razonablemente para permitir un procesamiento automático.

- No discriminatorio: los datos están disponibles a cualquiera, sin requerir un registro.

- No propietario: los datos están disponibles en un formato sobre el cual ninguna entidad tiene un control exclusivo.

- Libre de licencias: los datos no están sujetas a ningún derecho de autor, patenté, marca registrada o regulaciones de acuerdo de secreto. Razonable privacidad, limitaciones de seguridad y privilegios están permitidos.

El cumplimiento debe ser revisable.

Definiciones

"público" significa: Los principios de datos abiertos de gobierno no apuntan a que los datos deban ser públicos y abiertos. La privacidad, seguridad y otros asuntos pueden legalmente (y de derecho) prevenir que un conjuntos de datos se compartan públicamente. Más bien, estos principios especifican las condiciones de que los datos públicos deben cumplir para ser considerado "abierto"."data" significa: La información almacenada electrónicamente o grabada. Ejemplos de esto incluyen documentos, bases de contratos, transcripciones de audiencias, y eventos grabados en audio o video. Mientras los recursos de información no electrónicos, tales como artefactos físicos, no están sujetos a los principios de datos abiertos de gobierno, siempre es alentador que esos recursos estén disponibles por vía electrónica a la medida de lo posible."revisable" significa: Se debe designar una persona de contacto para responder a las personas que intenten usar los datos. Se debe designar Una persona de contacto para responder a las quejas sobre violaciones de los principios. Un tribunal administrativo o judicial debe tener la jurisdicción para examinar si los organismos han aplicado estos principios adecuadamente.

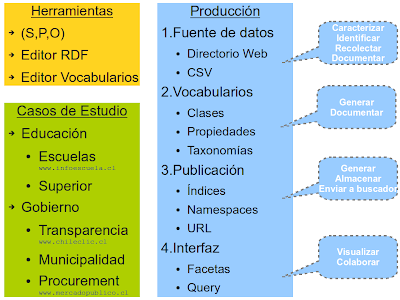

Modelo de datos abiertos

El modelo general para el tratamiento de datos abiertos se sintetiza de forma simple y clara en el sitio theinfo.org (iniciado por el mismo Aaron Swartz) y contempla tres niveles.

| Nivel | Obtener | Procesar | Visualizar |

| Items | scrapers crawlers phone calls buyouts | conversions queries regressions collaborative filtering | tables graphs maps web sites |